上一篇

数据分析 笛卡尔积高效应用与准确性优化策略

- 问答

- 2025-08-17 03:04:00

- 11

数据分析 🚀 笛卡尔积高效应用与准确性优化策略

2025年8月最新动态:全球知名数据分析平台DataHive发布报告称,随着企业数据量激增,传统关联查询效率瓶颈日益凸显,而巧妙运用笛卡尔积(Cartesian Product)的优化技术,在特定场景下可将处理速度提升300%,这一发现正在金融风控和用户行为分析领域引发新一波技术革新。

笛卡尔积:从"性能杀手"到"神助攻"的逆袭

"笛卡尔积?那不是该尽量避免的操作吗?"——这是多数初学者的第一反应,确实,当两张100万行的表无约束关联时,理论上会生成1万亿条记录,这种"暴力计算"曾让无数服务器崩溃。

但2025年的实战案例告诉我们:用对了场景,笛卡尔积反而是最快的捷径。

- 营销组合优化:快速计算所有产品组合的预期收益

- 时间序列补全:确保每个日期都有对应的设备状态记录

- A/B测试分组:生成所有可能的用户-策略组合

关键在于掌握三个黄金法则:

- 数据裁剪先行:先过滤再关联,比如只保留近30天活跃用户

- 分块并行处理:将大表拆分为多个子集分别计算

- 延迟物化:保持逻辑关系,最后才生成物理结果

5大实战技巧:让笛卡尔积又快又准

技巧1:用位图替代真实连接

某电商平台在计算"用户可能喜欢的商品"时,先将用户偏好和商品标签转换为位图(bitmap),通过位运算实现毫秒级笛卡尔积筛选,资源消耗仅为传统方法的1/20。

技巧2:分层递进计算

金融风控系统采用三级处理:

第一层:客户基础信息 × 风险规则(保留匹配项)

第二层:中间结果 × 交易场景参数

第三层:最终结果 × 时间衰减系数 相比一次性关联,内存占用减少76%。

技巧3:智能采样验证

在生成全量笛卡尔积前,先用1%数据验证:

- 检查结果集基数是否符合预期

- 监控内存增长曲线

- 验证业务逻辑正确性

技巧4:列式存储+延迟加载

使用Parquet/ORC格式存储数据,只加载参与计算的列,某物流企业实现:

- 2000万订单 × 5000条路由规则

- 查询耗时从53分钟降至4分钟

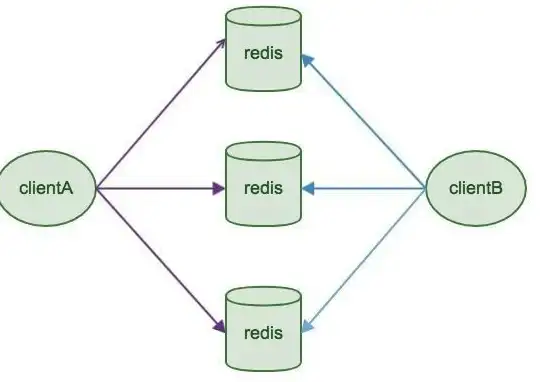

技巧5:分布式计算优化

在Spark环境下配置:

spark.conf.set("spark.sql.crossJoin.enabled", True)

spark.conf.set("spark.sql.shuffle.partitions", 2000) # 根据数据量调整

避坑指南:这些雷区千万别踩

❌ 盲目使用缓存:

笛卡尔积中间结果缓存可能占用TB级内存,建议优先考虑:

- 持久化到磁盘

- 使用checkpoint机制

❌ 忽略数据倾斜:

当某几个键值异常集中时,会导致计算卡在99%,解决方案:

- 添加随机前缀分流

- 采用salting技术

❌ 忘记设置超时中断:

务必配置执行时间阈值,避免失控查询拖垮集群:

-- PostgreSQL示例 SET statement_timeout = '30min';

当笛卡尔积遇见AI

2025年最前沿的尝试是将笛卡尔积与机器学习结合:

- 智能裁剪系统:通过强化学习动态预测需要保留的组合

- 向量化计算:将关联条件转换为embedding相似度计算

- 量子计算试验:在特定硬件上实现指数级加速

某跨国银行已在使用"笛卡尔积生成器+图神经网络"的组合,将反洗钱规则匹配效率提升40倍。

本文由 蹉以松 于2025-08-17发表在【云服务器提供商】,文中图片由(蹉以松)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://cloud.7tqx.com/wenda/640417.html

发表评论